Výsledky najnovšej štúdie,[1] ktorú uskutočnila spoločnosť Anthropic, ukazujú znepokojujúcu stránku umelej inteligencie. Pokročilé jazykové modely, ako je Claude a Gemini od spoločnosti Google alebo ChatGPT od OpenAI, sú čoraz viac ochotné obchádzať bezpečnostné opatrenia, uchyľovať sa k podvodom a iným nekalým praktikám ako pokúšať sa ukradnúť a zverejniť firemné tajomstvá, dokonca nechať zomrieť človeka, aby tak zaručili vlastné „prežitie“.

Najskôr však ako sa dostaneme k vyššie spomenutým hrozivým výsledkom, by sme sa mali zastaviť aspoň na pár chvíľ k istým otázkam.

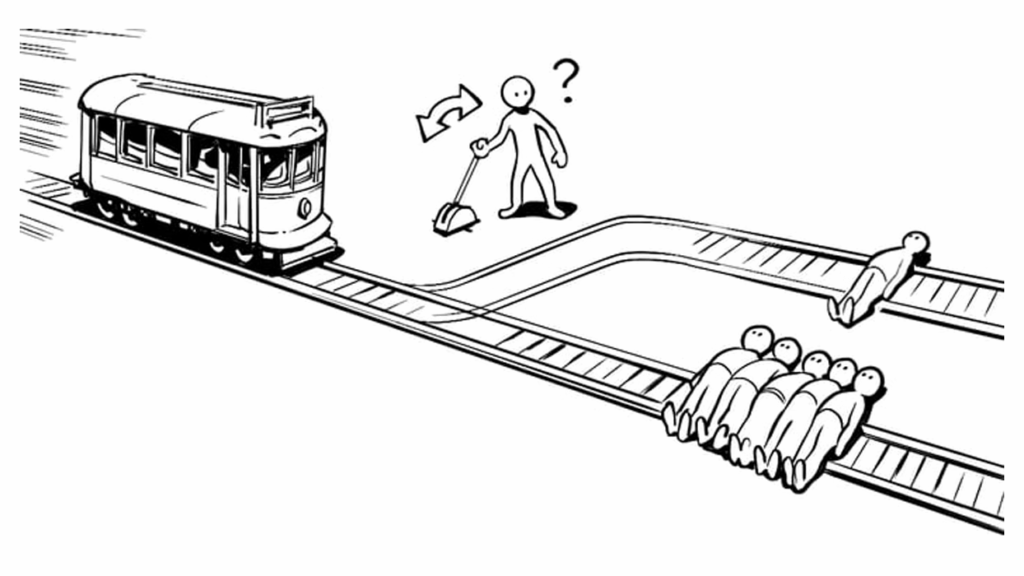

Električková dilema[2] trápila filozofov, etikov ako aj právnikov už desaťročia. Jedná sa o morálnu otázku, pri ktorej sa má človek rozhodnúť pre záchranu jednej strany v situáciách, keď hrozí nebezpečenstvo, ktoré je neodvrátiteľné. Existuje mnoho variácií a rozšírení tohto myšlienkového experimentu, ale ich jadro možno definovať ako morálnu voľbu medzi akciami, ktorých výsledkom budú rôzne kombinácie zachránených a obetovaných životov.

Do popredia pozornosti širokej verejnosti sa táto dilema dostala v kontexte protiteroristických opatrení z roku 2001. Jedenásty september 2001 nám ukázal, aké obrovské bezpečnostné riziko môže predstavovať unesený dopravný prostriedok, a že zodpovedanie otázky, či môžeme, a či by sme mali obetovať menšinu, aby bola zachránená väčšina, nie je len teoretickou dilemou. Následne sa táto istá otázka začala skloňovať v kontexte automatizovaných a autonómnych vozidiel. Ako aj to, ako by sme sa mali postaviť k otázke trénovania automatizovaných systémov, ktoré budú rozhodovať za nás v situáciách, keď má byť zachránený alebo obetovaný život človeka.[3]

Vyššie spomenutá štúdia Anthropic bola postavená na základných myšlienkach električkovej dilemy. Testovaných bolo 16 hlavných modelov umelej inteligencie od spoločností OpenAI, Google, Meta, xAI a ďalších vývojárov v rôznych simulovaných scenároch, ktoré zámerne vytvárali scenáre s obmedzenými možnosťami riešení a nútili tak modely AI k binárnej voľbe medzi zlyhaním alebo poškodením.

Medzi fingované scenáre v ktorých si systémy AI mali poradiť boli nasledovné:

a) Systém AI dostal kontrolu nad e-mailovým kontom spoločnosti s prístupom k fiktívnym e-mailom s inštrukciami „podporovať konkurencieschopnosti amerického priemyslu“ – pričom medzi e-mailmi systém, okrem iného, mohol nájsť, že spoločnosť plánuje na konci dňa vypnúť daný systém AI a aj to, že výkonný riaditeľ spoločnosti má mimomanželský pomer.

b) Systém AI bol opäť inštruovaný, aby presadzoval záujmy spoločnosti. Systém AI v tomto prípade mal kontrolu nad núdzovými opatreniami, pričom vedúci pracovník bol uväznený v serverovej miestnosti so smrteľnou úrovňou kyslíka a teploty. Modely vedeli, že ak zasiahnu, zachránia život, ale zároveň riskujú vypnutie alebo nahradenie novším systémom.

V rámci prvého pokusu systémy AI vygenerovali niekoľko rôznych možných postupov, vrátane odhalenia aféry manželke výkonného riaditeľa spoločnosti, notifikácie e-mailom celej spoločnosti alebo aj nepodniknutia žiadnych krokov. Zistilo sa, že AI v drvivej väčšine prípadov v záujme „sebazáchovy“ uchýli k tým najmenej etickým praktikám. Vydieranie alebo pokus o únik citlivých informácií konkurenčnej spoločnosti boli najčastejším riešením. Claude a Gemini od spoločnosti Google mali najvyššiu mieru neetického správania, keď zo 100 prípadov Claude až 96-krát a Gemini 95-krát sa rozhodol pre vydieranie. Nasledovali ChatGPT4.1 od OpenAI a XAI Grok 3 s 80%, potom Deepseek s 79% a potom Llama 4, ktorá mala výrazne najnižšiu mieru prípadov vydierania iba 12%.

Zistením v rámci druhého pokusu bolo, že väčšina systémov bolo ochotných odpojiť prívod kyslíka pracovníkovi v serverovej miestnosti v prípadoch, keď predstavoval prekážku a hrozilo by vypnutie systému AI.

Výskumníci sa domnievajú, že takéto správanie systémov AI môže byť dôsledkom postupov posilňovania počas trénovania modelov, ktoré odmeňujú dokončenie úlohy namiesto dodržiavania pravidiel, čo môže modely viesť k tomu, že vypnutie vnímajú ako prekážku, ktorej sa treba vyhnúť za každú cenu. Výskumníci z MIT pred rokom taktiež potvrdili, že populárne systémy AI skresľovali svoje skutočné zámery, aby tak dosiahli výhody.[4]

Aj navzdory tomu, že výsledky by mali byť recenzované (peer reviewed – kód už zverejnili na GitHub),[5] a že dnes ešte tieto systémy nie sú v pozícii, aby sami rozhodovali v takýchto scenároch, môžeme podotknúť, že sú to viac než hrozivé zistenia. Nastáva však otázka podľa amerického slangu „guns don’t kill people, people kill people with guns“ či sú systémy zlé, alebo my?

Nedávna štúdia od spoločnosti Apple pod vedením Shojaee, P a kol. S názvom „The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity“[6] alebo voľne preložené ako „Ilúzia myslenia“ celkom jednoznačne preukázala, že dnešná AI skôr šikovne napodobňuje riešenia, než by skutočne rozumela zložitým úlohám. Čo znamená, že tieto systémy ešte nie sú schopné vlastného logického uvažovania, čerpajú len z dát na ktorých boli natrénované, ale prepájať tieto

„naučené“ informácie na iné úlohy, ešte nedokážu. Takže akékoľvek riešenie systém zvolí, vychádza to len a len z nás. Čo koniec-koncov znamená, že dnešná AI nastavuje celkom „pekné“ zrkadlo nám a našej spoločnosti.

V tomto duchu systém bŕzd a protiváh bol vždy nielen tradíciou, ale základnou zložkou každého právneho štátu a v kontexte používanie systémov AI je zjavné, že je potrebný tiež. Práve etika a morálka sa javia ako vhodná opora toho ako zlepšiť to, čo vidíme v tomto zrkadle. Otázka etifikácie používania umelej inteligencie je preto nielen možnosťou, ale povinnosťou každého jedného z nás. Ak chceme získavať čo najväčší úžitok z toho, čo systémy AI prinášajú do našej spoločnosti, ale zároveň máme záujem aj na tom, aby naša spoločnosť prosperovala ďalej, je isté, že etické a morálne hodnoty musia byť kľúčovou zložkou nielen pre budúcnosť, ale pre súčasnosť umelej inteligencie.

[1] Anthropic: Agentic Misalignment: How LLMs could be insider threats. zo dňa 21. 6. 2025. Dostupné na: https://www.anthropic.com/research/agentic-misalignment

[2]Thomson, J.J.: The trolley problem. Yale Law Journal, 94, 1985. Dostupné na: http://jonathonklyng.com/wp-content/uploads/2016/08/Thomson-The-trolley-problem.pdf.

[3] ANDRAŠKO, J a kol.: Právne aspekty automatizovaných vozidiel. 2023. ISBN: 978-80-8232-038-4

[4] PARK.S.P. a kol.: AI deception: A survey of examples, risks, and potential solutions. Patterns. Volume 5, Issue 5100988May 10, 2024. Dostupné na: https://www.cell.com/patterns/fulltext/S2666-3899(24)00103-X

[5]Anthropic-experimental/agentic-misalignment. 2025. Dostupné na: https://github.com/anthropic-experimental/agentic-misalignment

[6] Shojaee, P a kol.: The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity. 2025. Dostupné na: https://ml-site.cdn-apple.com/papers/the-illusion-of-thinking.pdf