Umelá inteligencia (ďalej len ako „AI“) dokáže napísať zmluvu či napríklad pripraviť hotový rešerš v priebehu niekoľkých sekúnd , no za prípadné chyby v týchto dokumentoch a za zavádzajúce výstupy stroja stále nesie plnú zodpovednosť jediná osoba, ktorou je práve advokát. Slovenská advokátska komora (ďalej len ako „SAK“) preto reagovala koncom minulého roka na tento technologický rozmach metodickým usmernením,[1] ktoré ponúka advokátom jasné pravidlá pri používaní AI v praxi, no čo je dôležitejšie, ponúka aj tzv. rozhodovací test pred vložením informácií chránených mlčanlivosťou do systému AI a vzorové informačné doložky. Novo zavedené pravidlá používania AI smerujú k zásadnému aspektu, a to: hoci môže byť umelá inteligencia skvelým pomocníkom, v rukách neopatrného právnika predstavuje vážne etické či bezpečnostné riziko, a to najmä v oblasti ochrany dát klientov, ktorí sa na právnika spoliehajú.

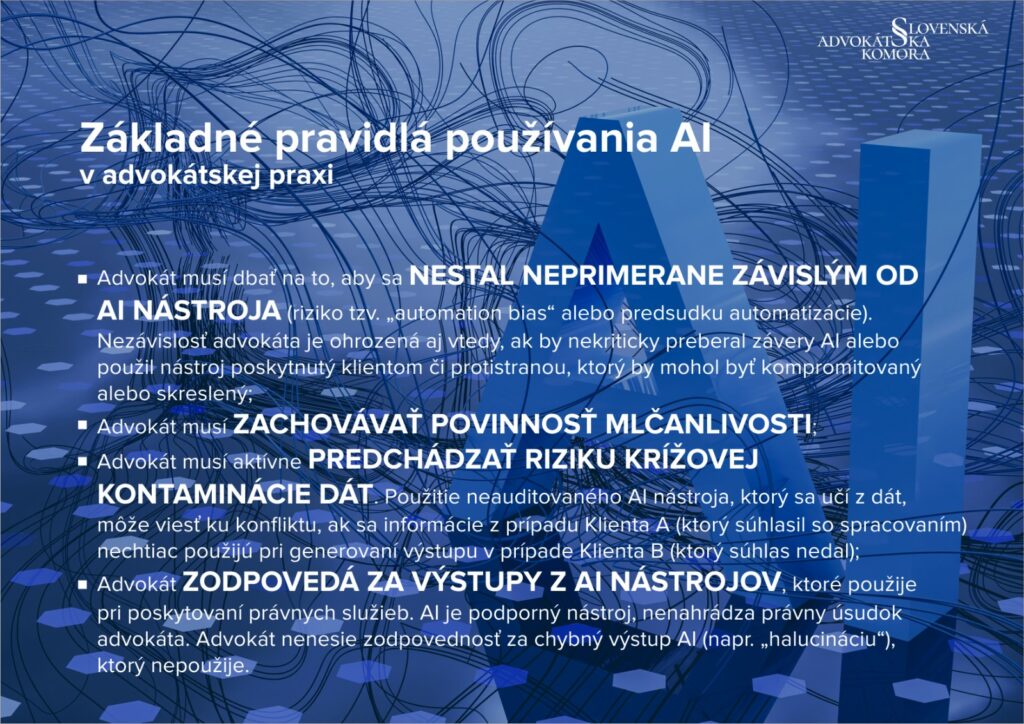

Prvú povinnosť advokáta by sme mohli nazvať ako plná zodpovednosť a ľudský dohľad, pri ktorých advokát nesie výlučnú a plnú zodpovednosť za výstupy z AI nástrojov,[2] ktoré použije pri poskytovaní právnych služieb. AI je definovaná výhradne ako podporný nástroj, ktorý nenahrádza odborné právne posúdenie ani individuálny prístup k prípadu. Pri práci advokáta je teda neprípustné spoliehať sa na výstupy AI bez ľudského preskúmania a finálnej autorizácie advokátom (čl. 3 ods. 2 metodického usmernenia).

Druhá povinnosť, ktorou je ochrana mlčanlivosti a vykonanie rozhodovacieho testu[3] smeruje práve k dôležitému aspektu ochrany dát týkajúcich sa klienta. V súčasnej dobe automatizácie a digitalizácie je nutné prejsť do prísnejšieho režimu, v ktorom je advokát povinný vykonať takýto rozhodovací test prípustnosti pred každým vložením dôverných informácií o svojom klientovi do systému AI. Tento test funguje ako trojstupňový filter, ktorý má advokátovi pomôcť určiť mieru rizika pri práci s klientskymi dátami a stanoviť potrebný právny základ pre ich následné spracovanie v prostredí AI. V prvej fáze advokát analyzuje technický režim nástroja, pričom pri lokálnych riešeniach alebo profesionálnych službách so zmluvne garantovaným zákazom trénovania modelu (tzv. režim spracovateľa) môže pracovať bez osobitného súhlasu klienta, zatiaľ čo pri verejných neauditovaných systémoch, ktoré dáta ukladajú na ďalšie učenie, je testom vyžadovaný výslovný a informovaný súhlas klienta. Druhý krok testu ukladá povinnosť dôslednej anonymizácie alebo minimalizácie údajov pred ich vložením do systému tak, aby sa v maximálnej možnej miere zabránilo spätnej identifikácii klienta. V záverečnej fáze, ak nie je možné dáta anonymizovať a advokát zvolí rizikovejší

verejný nástroj, musí od klienta preukázateľne získať podpísanú doložku o zbavení mlčanlivosti, čím sa prenáša vedomosť o bezpečnostných rizikách priamo na klienta a zabezpečuje sa súlad s etickými aj zákonnými povinnosťami advokáta.

V poradí tretia povinnosť je povinná verifikácia a eliminácia rizika halucinácií, ktorá vzhľadom na špecifickú technickú povahu generatívnych modelov ukladá advokátovi striktnú povinnosť podrobiť každý výstup z umelej inteligencie dôslednej kritickej kontrole.[4] Dokument v tejto súvislosti priamo definuje a varuje pred javom známym ako „halucinácia“, ktorý označuje situácie, kedy umelá inteligencia generuje odpovede, ktoré sú fakticky nesprávne, neexistujúce alebo zavádzajúce, hoci navonok pôsobia vysoko odborne a presvedčivo. Podľa usmernenia ide o prirodzenú vlastnosť pravdepodobnostných modelov, ktoré nedisponujú skutočným poznaním práva, ale iba štatisticky predpovedajú nasledujúce slová v texte, čo môže viesť napríklad k vytváraniu fiktívnych právnych noriem alebo neexistujúcej judikatúry.[5] V praxi táto definícia znamená, že advokát nesmie dôverovať žiadnej informácii, ktorú si sám spätne neoveril v primárnych a oficiálnych zdrojoch práva. Povinnosť verifikácie sa vzťahuje predovšetkým na kontrolu existencie a účinnosti citovaných právnych predpisov, ako aj na preverovanie pravdivosti súdnych rozhodnutí, pri ktorých AI

často generuje neexistujúce spisové značky alebo si vymýšľa právne vety. Usmernenie zdôrazňuje, že ak advokát nekriticky preberie „halucinovaný“ výstup do svojho podania, dopúšťa sa závažného porušenia povinnosti poskytovať právne služby s odbornou starostlivosťou. Za takéto pochybenie nesie advokát plnú disciplinárnu zodpovednosť a nemôže sa jej zbaviť odvolaním sa na technickú chybu alebo nepredvídateľnosť použitého nástroja (variant 1 – informačná doložka (režim c), čl. 10 – Využívanie softvérových nástrojov a AI metodického usmernenia).[6]

Zachovanie nezávislosti a prevencia technologického skreslenia sú štvrtým pravidlom, pri ktorom je advokát pri využívaní umelej inteligencie povinný striktne zachovávať svoju profesionálnu nezávislosť a nenechať sa ovplyvniť javom známym ako „automation bias“,[7] teda nekritickou tendenciou dôverovať automatizovaným systémom na úkor vlastného odborného úsudku. Výkon advokácie teda musí mať výsostne osobný charakter, čo znamená, že technológia nesmie nahradiť strategické právne uvažovanie, individuálne hodnotenie dôkazov ani hľadanie kreatívnych právnych riešení šitých na mieru klientovi. Nezávislosť musí advokát strážiť aj v situáciách, kedy mu sú konkrétne AI nástroje ponúknuté alebo nanútené protistranou či inými subjektmi, aby sa predišlo skrytému ovplyvňovaniu výsledku právnej pomoci algoritmami.

Nové pravidlá rozširujú štandard odbornej spôsobilosti advokáta taktiež aj o povinnosť primeranej digitálnej gramotnosti v oblasti umelej inteligencie, čo zahŕňa schopnosť porozumieť nielen výhodám, ale najmä limitom a bezpečnostným rizikám implementovaných nástrojov. V tejto súvislosti je posledným piatym pravidlom AI gramotnosť a zodpovednosť za dohľad nad tímom. Táto zodpovednosť presahuje rámec individuálneho výkonu a ukladá advokátovi povinnosť preukázateľne zaškoliť svojich koncipientov, zamestnancov a iné spolupracujúce osoby o etických a právnych pravidlách používania AI (čl. 3 ods. 4 metodického usmernenia). Súčasťou riadneho výkonu advokácie je tak po novom aj zavedenie jasných vnútorných predpisov, ktoré definujú schválené nástroje a postupy, čím sa zabezpečí, že technologický pokrok v rámci kancelárie neohrozí záujmy klientov a ani dôstojnosť advokátstva.

V súčasnej advokátskej praxi sa teda nové pravidlá používania AI transformujú predovšetkým do povinnosti transparentne informovať klienta a vykonať precízny rozhodovací test pred spracovaním akýchkoľvek údajov. Praktická implementácia týchto pravidiel tak vyžaduje nielen technické zabezpečenie lokálnych riešení či platených profesionálnych licencií, v ktorých si za čas strávený zaškolením seba samého v pozícii advokáta nesmie účtovať peniaze klientovi, so zákazom učenia sa na klientskych dátach, ale aj zavedenie jasných internýchsmerníc, ktoré definujú, za akých podmienok a v akom rozsahu môžu koncipienti a zamestnanci tieto nástroje pri tvorbe právnych textov využívať.

Dôležitosť týchto preventívnych opatrení a osobnej verifikácie každého výstupu zdôrazňuje aj nedávne rozhodnutie Ústavného súdu Českej republiky,[8] ktorý uložil advokátovi pokutu za nekritické použitie AI pri koncipovaní ústavnej sťažnosti. Súd v tomto prípade sankcionoval skutočnosť, že podanie obsahovalo fiktívnu právnu argumentáciu opretú o neexistujúci judikát, čo umelá inteligencia vygenerovala v rámci halucinovania. Tento precedens jasne demonštruje, že zodpovednosť za odbornú úroveň právnej služby zostáva výlučne na advokátovi, ktorý sa pod text podpísal, a žiadne technické zlyhanie nástroja ho nezbavuje povinnosti kontrolovať súlad podania s reálnym právnym stavom. Pre advokátov z toho vyplýva kategorický príkaz overovať každú citáciu a právnu vetu v oficiálnych zdrojoch, aby sa vyhli nielen procesným neúspechom, ale aj vážnym disciplinárnym a finančným dôsledkom. [8]

V súčasnosti prechádza advokátska prax zásadnou transformáciou, ktorú SAK reflektovala prijatím predmetného metodického usmernenia definujúceho prísny etický a normatívny rámec pre prácu s AI. Ako potvrdili najvyšší predstavitelia justície na stretnutí už vo februári 2025, vrátane vtedajšieho predsedu Najvyššieho súdu Slovenskej republiky Jána Šikutu, AI disponuje vysokým potenciálom zefektívniť rutinné právne úkony, avšak jej implementácia nesmie ohroziť podstatu justičných povolaní ani princípy právneho štátu.[9] Kľúčom k bezpečnej integrácii je dodržiavanie piatich základných pilierov: výlučnej zodpovednosti advokáta za každý výstup, aplikácie záväzného rozhodovacieho testu na ochranu mlčanlivosti, dôslednej verifikácie proti riziku halucinácií, zachovania profesionálnej nezávislosti a zvyšovania AI gramotnosti celého tímu. Výstražným mementom zostáva nedávna sankcia Ústavného súdu ČR uložená advokátovi za nekritické použitie AI, čo potvrdzuje, že technologický pokrok nikdy nezbavuje advokáta jeho osobnej zodpovednosti za odbornú úroveň a integritu poskytovanej právnej pomoci.

[1] Uznesenie Predsedníctva Slovenskej advokátskej komory č. 12/4/2025 z 31. marca 2025, ktorým sa schvaľujú pravidlá používania nástrojov umelej inteligencie v advokátskej praxi v znení Uznesenia Predsedníctva Slovenskej advokátskej komory č. 21/14/2025 zo 6. novembra 2025, uverejnené dňa 25. novembra 2025 v čiastke 87 Vestníka SAK. Dostupné online na webovom sídle: https://info.sak.sk/wp-content/uploads/2025/12/Uznesenie_12-4-2025_plne-znenie-k-25-11-2025.pdf.

[2] Metodické usmernenie Predsedníctva Slovenskej advokátskej komory k Uzneseniu Predsedníctva Slovenskej advokátskej komory č. 21/14/2025 zo 6. novembra 2025 vo svojom

článku 2 písm. a) definuje AI nástroj ako: „softvérový alebo systémový nástroj využívajúci strojové učenie, generatívne algoritmy alebo iné formy umelej inteligencie na spracovanie, analýzu alebo generovanie informácií“.

[3] Článok 4 Uznesenia Predsedníctva Slovenskej advokátskej komory č. 12/4/2025 z 31. marca 2025, ktorým sa schvaľujú pravidlá používania nástrojov umelej inteligencie v advokátskej praxi v znení Uznesenia Predsedníctva Slovenskej advokátskej komory č. 21/14/2025 zo 6. novembra 2025, uverejnené dňa 25. novembra 2025 v čiastke 87 Vestníka SAK, ktorý pozostáva z troch otázok (viď. obrázok pod textom).

[4] K tzv. „halucinovaniu“ systémov AI pozri: SALVAGNO, M. TACCONE, F. S. & GERLI, A. G. Artificial intelligence hallucinations. Crit Care 27, 180. 2023. DOI: https://doi.org/10.1186/s13054-023-04473-y.

[5] Článok 2 písm. f) Uznesenia Predsedníctva Slovenskej advokátskej komory č. 12/4/2025 z 31. marca 2025, ktorým sa schvaľujú pravidlá používania nástrojov umelej inteligencie v advokátskej praxi v znení Uznesenia Predsedníctva Slovenskej advokátskej komory č. 21/14/2025 zo 6. novembra 2025, uverejnené dňa 25. novembra 2025 v čiastke 87 Vestníka SAK, a to v znení: „halucinácia – jav, pri ktorom AI nástroj generuje fakticky nesprávne, zavádzajúce alebo úplne vymyslené informácie (napr. neexistujúce judikáty či citácie), ktoré sa však javia ako presvedčivé“.

[6] K otázke využívania AI napríklad v Nemecku pozri: RENNIG, C. (2025). The Use of Artificial Intelligence and the Professional Duties of German Lawyers. In: Studia Prawa Publicznego, (1 (49), s. 49–63. 2025. DOI: https://doi.org/10.14746/spp.2025.1.49.3.

[7] LAUX, J. a RUSCHEMEIER, H. Automation Bias in the AI Act: On the Legal Implications of Attempting to De-Bias Human Oversight of AI. 2025. S. 3-4. Dostupné online na webovom sídle: https://arxiv.org/pdf/2502.10036.

[8] Napríklad platforma Praktik.ai predstavuje pre advokátov špecializované prostredie navrhnuté priamo pre slovenskú legislatívu, ktorý v súlade s novými pravidlami SAK funguje ako bezpečný a odborný asistent pri spracovaní právnych rešerší, analýze spisov či draftovaní dokumentov. Z hľadiska rozhodovacieho testu prípustnosti je dôležité, že tento nástroj rešpektuje najprísnejšie nároky na ochranu mlčanlivosti a ochranu osobných údajov, nakoľko umožňuje prácu v režime, kde sa vložené klientske dáta nepoužívajú na ďalší tréning verejných modelov, čím advokátovi odpadá povinnosť získavať výslovný súhlas klienta pri zachovaní vysokej miery informačnej bezpečnosti. Platforma dostupná online na webovom sídle: https://praktik.ai/.

[9] Webové sídlo Najvyššieho súdu Slovenskej republiky, príspevok s názvom „Umelá inteligencia má potenciál zefektívniť právne služby“. Dostupné online na webovom sídle: https://www.nsud.sk/umela-inteligencia-ma-potencial-zefektivnit-pravne-sluzby/.